为什么选择 AlexHost 满足您的人工智能和 GPU 托管需求?值得信赖的性能

在快速发展的人工智能、机器学习和高性能计算领域,基础设施就是一切。无论您是在训练大规模神经网络、运行推理管道,还是在构建基于计算机视觉和LLM 的系统,底层硬件都可能决定计算时间的长短。这正是 AlexHost 脱颖而出的原因 – 为人工智能创新者、研究人员和企业提供高度专业化、性能优化的 GPU 托管生态系统。

专为人工智能工作负载打造

AlexHost 并不是一个碰巧提供 GPU 的通用托管服务提供商。它是一个专门为支持计算要求苛刻的人工智能任务而设计的平台–从深度学习和模型微调到大规模生成人工智能和数据科学。

1.高性能 GPU 基础设施

AlexHost 服务的核心是由英伟达™(NVIDIA®)驱动的服务器阵容,配备行业领先的 GPU,如

- 英伟达™(NVIDIA®)Tesla P4 – 针对高吞吐量推理和模型部署进行了优化。

- NVIDIA RTX 4070 Ti / 5080– 功能强大的多用途 GPU,适用于训练、渲染和模拟工作负载。

- 多 GPU 配置– 适用于需要并行化、分布式学习或密集图形渲染的用例。

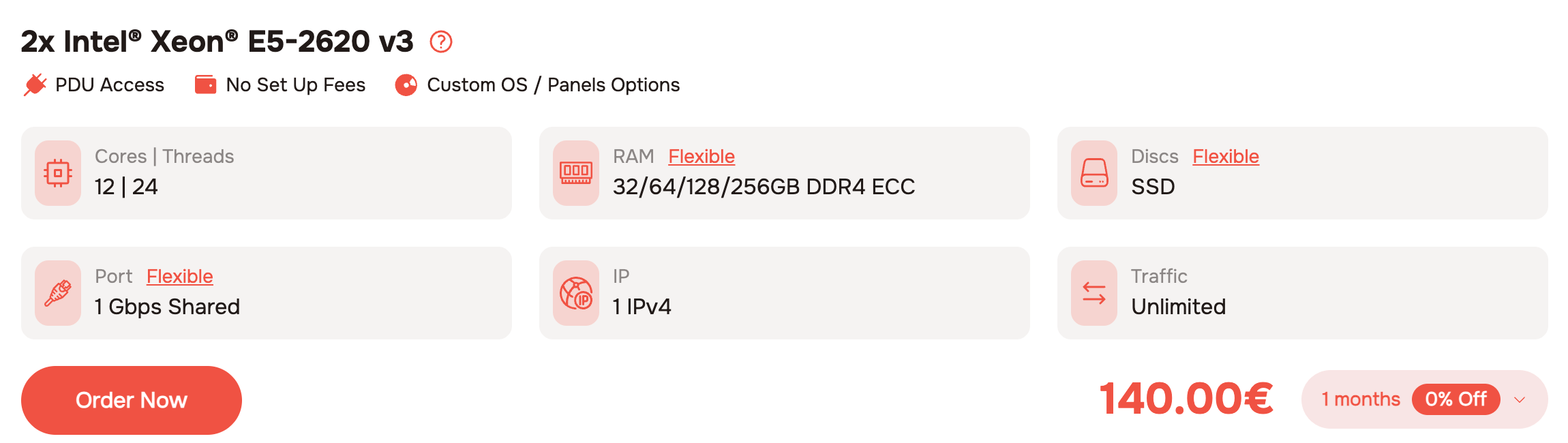

AlexHost 的 Tesla P4 服务器将高能效 GPU 加速与双Intel Xeon CPU和高达 256 GB ECC RAM 相结合,为实时人工智能推理和机器学习工作负载提供可靠、经济高效的性能。

2.具有完全 Root 访问权限的裸机功能

AlexHost 提供真正的裸机 GPU 托管 – 而不是共享虚拟实例。您可以获得专用性能,而无需虚拟化开销,还可以通过完全 root 访问配置您的人工智能环境,安装自定义驱动程序,或使用 Docker、Kubernetes 或 Singularity 等工具部署容器化 ML 管道。

3.低延迟网络和 10 Gbps 上行链路

人工智能工作负载在训练和模型部署期间通常需要大量的数据传输。凭借高达10 Gbps 的上行链路,AlexHost 可确保数据集、检查点和推理结果在堆栈中快速移动。这对于实时人工智能应用、边缘部署和协作研究环境至关重要。

专为开发人员、数据科学家和企业设计

无论您是单独的 ML 工程师、人工智能初创企业,还是具有复杂部署需求的企业,AlexHost 都有一个生态系统来支持您的愿景。

✔️针对每种使用情况的可扩展定价

从用于 LLM 微调和稳定扩散生成的入门级配置,到用于联合学习或视频 AI 的多 GPU 节点 – AlexHost 提供灵活的按小时/按月计费方式,无隐藏费用,与 AWS 或 GCP 等云巨头相比,具有显著的性价比优势。

✔️预配置环境或自带堆栈

您可以从预先配置的堆栈(Ubuntu + CUDA + PyTorch/TensorFlow)开始,也可以手动安装您喜欢的发行版和环境。这种灵活性可实现与 CI/CD 管道和版本控制系统的无缝集成,从而提高模型的可重复性。

✔️隐私、安全和合规性

通过 AlexHost 在摩尔多瓦的离岸托管管辖区,您的数据将受到严格的隐私法律和中立的地缘政治立场的保护。对于需要加强保密性、法规隔离或专有研发工作的项目而言,这是一个理想的解决方案。

为什么开发人员信赖 AlexHost

- ✅透明定价– 无意外收费,清晰的计费模式。

- ✅快速部署– 利用预装的 CUDA 和驱动程序在几分钟内配置服务器。

- ✅专家支持– 由真正的工程师而不仅仅是销售代表提供 24/7 基于票据的支持。

- ✅定制配置– 根据您的工作负载要求特定的硬件设置。

- ✅全球覆盖,离岸优势– 国际连接和数据隐私的融合。

AlexHost 不仅仅是另一家 GPU 供应商,它还是您人工智能之旅的战略合作伙伴。凭借强大的英伟达™(NVIDIA®)硬件、低延迟网络和可定制的环境,AlexHost 使开发人员和数据科学家能够满怀信心地进行构建、迭代和部署。