使用 AlexHost 的尖端 GPU 托管加速人工智能开发

在快速发展的人工智能领域,计算能力至关重要。无论您是在训练大型语言模型、部署计算机视觉应用程序,还是在开发人工智能生成系统,AlexHost 的 GPU 托管解决方案都能提供满足这些需求所需的强大基础设施。

为高要求的人工智能工作负载而构建

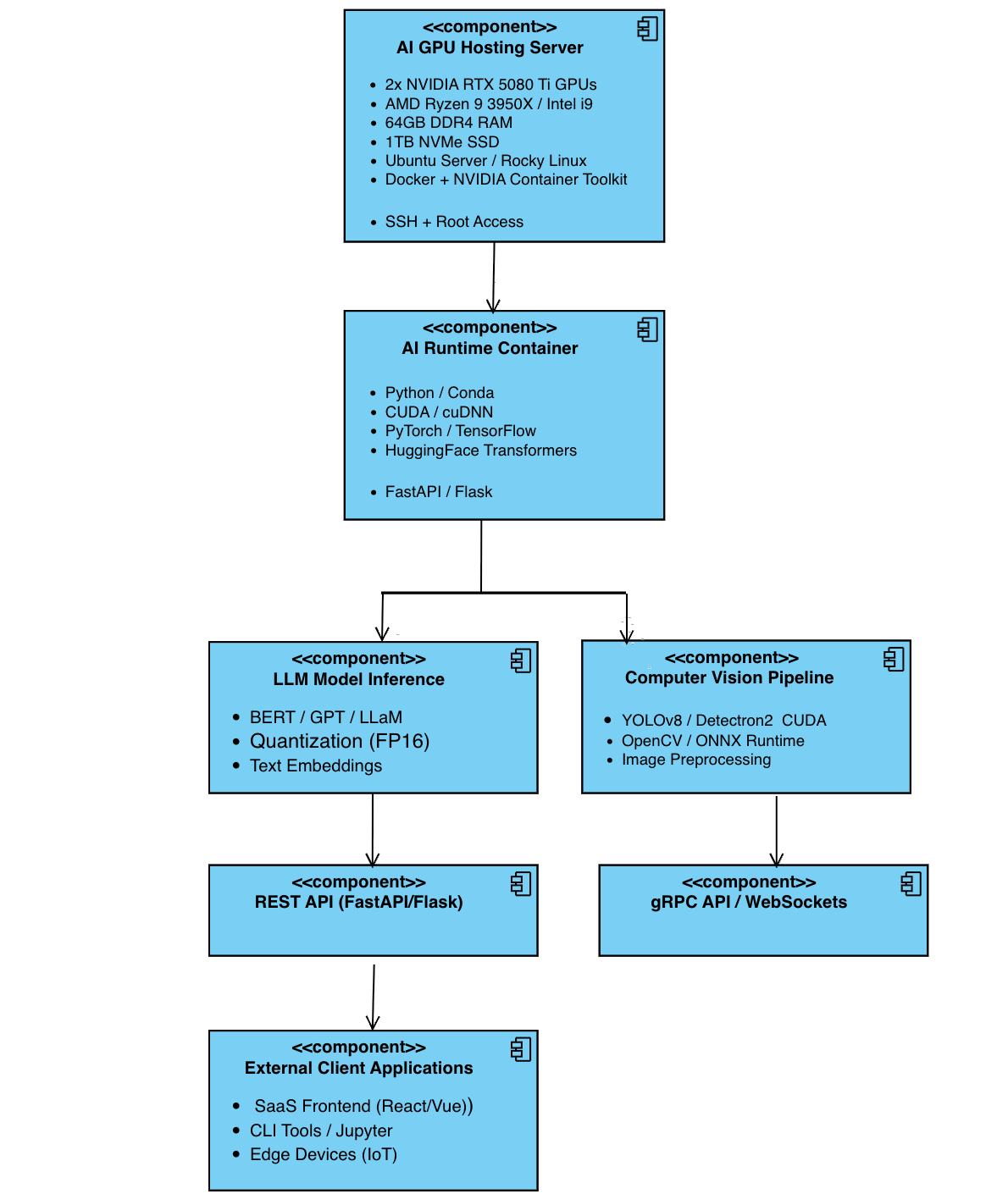

AlexHost 的GPU 托管基础设施经过精心设计,可支持密集型人工智能工作负载,强调深度学习、模型训练和大规模推理。该平台采用高吞吐量、低延迟架构,由2x NVIDIA GeForce RTX 5080 Ti GPU 驱动,以其 CUDA 内核密度、内存带宽和并行计算能力而闻名。

这些系统针对高级人工智能应用进行了优化,包括

- 需要持续 FP16/FP32 计算和高 VRAM 利用率的有监督和无监督深度学习训练。

- 微调基于变压器的架构,如 LLM(如 BERT、GPT)、扩散模型和 GAN,需要快速互连和大量内存吞吐量。

- 自然语言处理(NLP)任务,如序列建模、文本分类和上下文嵌入,利用高内核并行性和 GPU 加速。

- 计算机视觉应用,包括实时物体检测、分割、OCR 和多帧监控分析。

- 边缘人工智能和联合学习场景,在这些场景中,低延迟 GPU 处理对于分布式、隐私保护学习和设备推理至关重要。

AlexHost 的基础架构支持直通式 PCIe 访问和真正的裸机部署,消除了虚拟化开销,并允许用户直接访问整个 GPU 资源堆栈。这对于需要精确硬件调整、确定性能以及与低级 CUDA 或 ML 框架优化(如 NCCL、cuDNN、TensorRT)兼容的场景来说至关重要。

与您一起扩展的配置

AlexHost 提供模块化和性能调优的 GPU 服务器组合,旨在根据人工智能开发不断变化的需求进行扩展。用户可以选择不同的硬件配置,包括

- 2x NVIDIA GeForce RTX 5080 Ti GPU:每个GPU配备16GB GDDR6X内存,总计32GB VRAM,为人工智能工作负载提供卓越性能。

- 英特尔酷睿 i9-7900X:10 个核心,适用于高频任务。

- AMD Ryzen™ 9 3950X:16 个核心,提供强劲的多线程性能。

- 内存:64GB DDR4 内存,确保为复杂的多线程 AI 任务提供充足的容量。

- 存储 1TB NVMe SSD,为大型数据集和模型检查点提供高速数据访问。

- 网络 1 Gbps 带宽,为分布式训练和实时推理提供快速数据传输。

- IP 配置:包含 1 个 IPv4/IPv6 地址。

这些配置非常适合构建人工智能驱动的 SaaS 产品的初创企业、运行复杂模拟的研究机构或部署大规模人工智能模型的企业。

隐私至上的人工智能创新托管服务–增强型

除了原始性能和可扩展性外,AlexHost 还优先考虑数据保护、基础设施隔离和主权计算控制 – 使其成为隐私敏感型人工智能开发和部署的理想环境。

全面数据控制与合规隔离

AlexHost 提供具有独家硬件分配的裸机 GPU 服务器,确保:

- 虚拟化层或共享管理程序不会产生侧通道泄漏风险。

- 每个客户的所有内存、GPU 和磁盘资源都是隔离的,消除了噪声邻居效应或未经授权的跨租户访问。

- 无共享租户– 您的模型、数据集和运行时环境完全由您控制。

这种基础架构尤其适用于

- 数据集必须保持在服务器本地的联合学习和保密人工智能培训。

- 使用敏感的医疗、法律或金融数据进行隐私保护模型微调。

- 为需要独立监管的企业客户提供安全的本地式云计算。

用于敏感人工智能开发的裸机架构

我们的裸机 GPU 托管可确保

- 主机系统的完全 root 访问权限,能够安装加固的 Linux 内核、审计日志工具、磁盘加密 (LUKS) 或安全飞地。

- 本地支持底层优化库(cuDNN、NCCL、TensorRT),具有确定的性能和最大的 GPU 吞吐量。

- 通过自定义防火墙/NAT 配置,能够部署与公共互联网物理隔离的空气屏蔽训练节点。

AlexHost 客户还可以使用自己的管理程序堆栈(如 Proxmox、KVM、Xen),在具有 GPU 能力的节点上构建私有云–让 DevOps 和 MLOps 团队完全控制基础设施和工作负载调度。